文章詳情頁

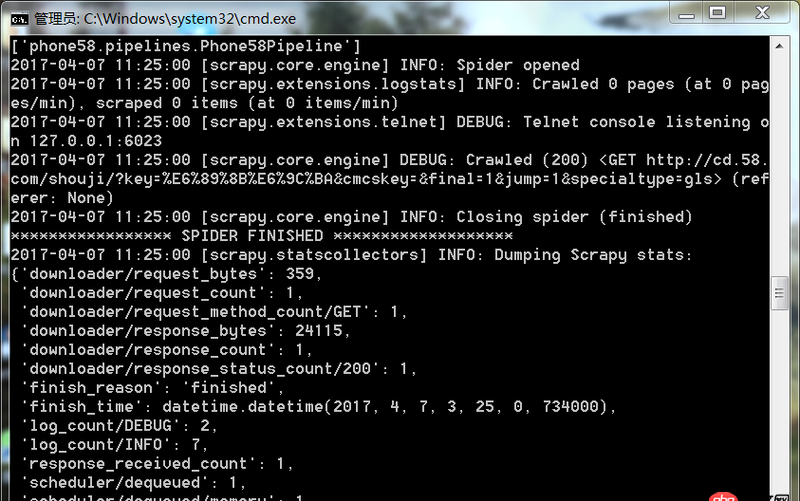

python - scrapy運行爬蟲一打開就關(guān)閉了沒有爬取到數(shù)據(jù)是什么原因

瀏覽:124日期:2022-08-05 15:09:38

問題描述

爬蟲運行遇到如此問題要怎么解決

問題解答

回答1:很可能是你的爬取規(guī)則出錯,也就是說你的spider代碼里面的xpath(或者其他解析工具)的規(guī)則錯誤。導(dǎo)致沒爬取到。你可以把網(wǎng)址print出來,看看是不是[]

相關(guān)文章:

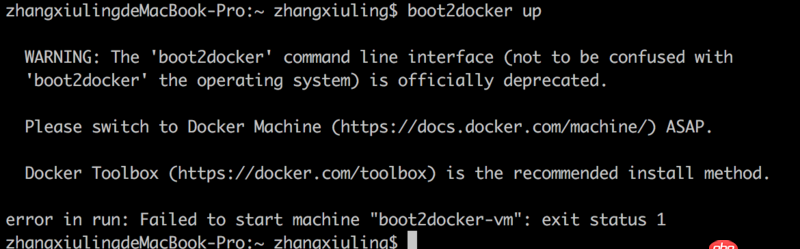

1. docker-compose中volumes的問題2. boot2docker無法啟動3. 關(guān)docker hub上有些鏡像的tag被標(biāo)記““This image has vulnerabilities””4. docker安裝后出現(xiàn)Cannot connect to the Docker daemon.5. nignx - docker內(nèi)nginx 80端口被占用6. java - SSH框架中寫分頁時service層中不能注入分頁類7. docker容器呢SSH為什么連不通呢?8. 關(guān)于docker下的nginx壓力測試9. java - Spring事務(wù)回滾問題10. dockerfile - 為什么docker容器啟動不了?

排行榜

熱門標(biāo)簽

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備