python爬蟲調(diào)度器用法及實例代碼

我們一般使用爬蟲看到的都是最后的數(shù)據(jù)結(jié)果,對于整個的獲取過程沒有過多了解過。對于初學(xué)python的小伙伴們來說,不光是代碼的練習(xí),還是原理的分析都是必不可少的。

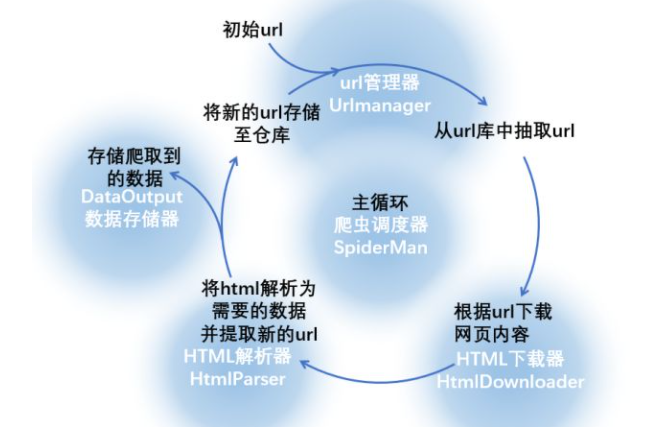

小編把整個爬取的過程分為了幾個部分,從一開始的下載,到數(shù)據(jù)的去重解析,再到整個爬蟲循環(huán)的結(jié)束,以圖片和代碼的雙重形式展現(xiàn)給大家,希望能夠?qū)ε老x調(diào)度器有一個深刻的理解。

我們可以編寫幾個元件,每個元件完成一項功能,下圖中的藍(lán)底白字就是對這一流程的抽象:

爬蟲調(diào)度器將要完成整個循環(huán),下面寫出python下爬蟲調(diào)度器的程序:

# coding: utf-8new_urls = set()data = {}class SpiderMan(object): def __init__(self): #調(diào)度器內(nèi)包含其它四個元件,在初始化調(diào)度器的時候也要建立四個元件對象的實例 self.manager = UrlManager() self.downloader = HtmlDownloader() self.parser = HtmlParser() self.output = DataOutput() def spider(self, origin_url): #添加初始url self.manager.add_new_url(origin_url) #下面進入主循環(huán),暫定爬取頁面總數(shù)小于100 num = 0 while(self.manager.has_new_url() and self.manager.old_url_size()<100): try: num = num + 1 print '正在處理第{}個鏈接'.format(num) #從新url倉庫中獲取url new_url = self.manager.get_new_url() #調(diào)用html下載器下載頁面 html = self.downloader.download(new_url) #調(diào)用解析器解析頁面,返回新的url和data try: new_urls, data = self.parser.parser(new_url, html) except Exception, e: print e for url in new_urls: self.manager.add_new_url(url) #將已經(jīng)爬取過的這個url添加至老url倉庫中 self.manager.add_old_url(new_url) #將返回的數(shù)據(jù)存儲至文件 self.output.store_data(data) print 'store data succefully' print '第{}個鏈接已經(jīng)抓取完成'.format(self.manager.old_url_size()) except Exception, e: print e #爬取循環(huán)結(jié)束的時候?qū)⒋鎯Φ臄?shù)據(jù)輸出至文件 self.output.output_html()

從整個循環(huán)的流程我們可以看出,由爬蟲調(diào)度器指揮四個元件完成數(shù)據(jù)的抓取、篩選、保存流程,并以此為基礎(chǔ)還可以進行新的循環(huán)。看懂原理之后,我們就可以使用以上的代碼進行實戰(zhàn)啦。

到此這篇關(guān)于python爬蟲調(diào)度器用法及實例代碼的文章就介紹到這了,更多相關(guān)python爬蟲調(diào)度器是什么內(nèi)容請搜索好吧啦網(wǎng)以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持好吧啦網(wǎng)!

相關(guān)文章:

1. Java如何基于反射機制獲取不同的類2. Android table布局開發(fā)實現(xiàn)簡單計算器3. jQuery 實現(xiàn)DOM元素拖拽交換位置的實例代碼4. IntelliJ IDEA安裝插件的方法步驟5. php模擬實現(xiàn)斗地主發(fā)牌6. 理解PHP5中static和const關(guān)鍵字7. Vue封裝一個TodoList的案例與瀏覽器本地緩存的應(yīng)用實現(xiàn)8. python 代碼實現(xiàn)k-means聚類分析的思路(不使用現(xiàn)成聚類庫)9. .Net Core使用Coravel實現(xiàn)任務(wù)調(diào)度的完整步驟10. PHP安全-命令注入

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備